Harvard y MIT logran un ordenador cuántico de 3.000 cúbits en funcionamiento continuo durante horas

Por primera vez, un ordenador cuántico basado en átomos neutros ha mantenido 3.000 cúbits estables durante más de dos horas, sin apagarse ni reiniciarse. El hito abre la puerta a máquinas cuánticas persistentes capaces de transformar la ciencia, la tecnología y la industria.

Por Enrique Coperías

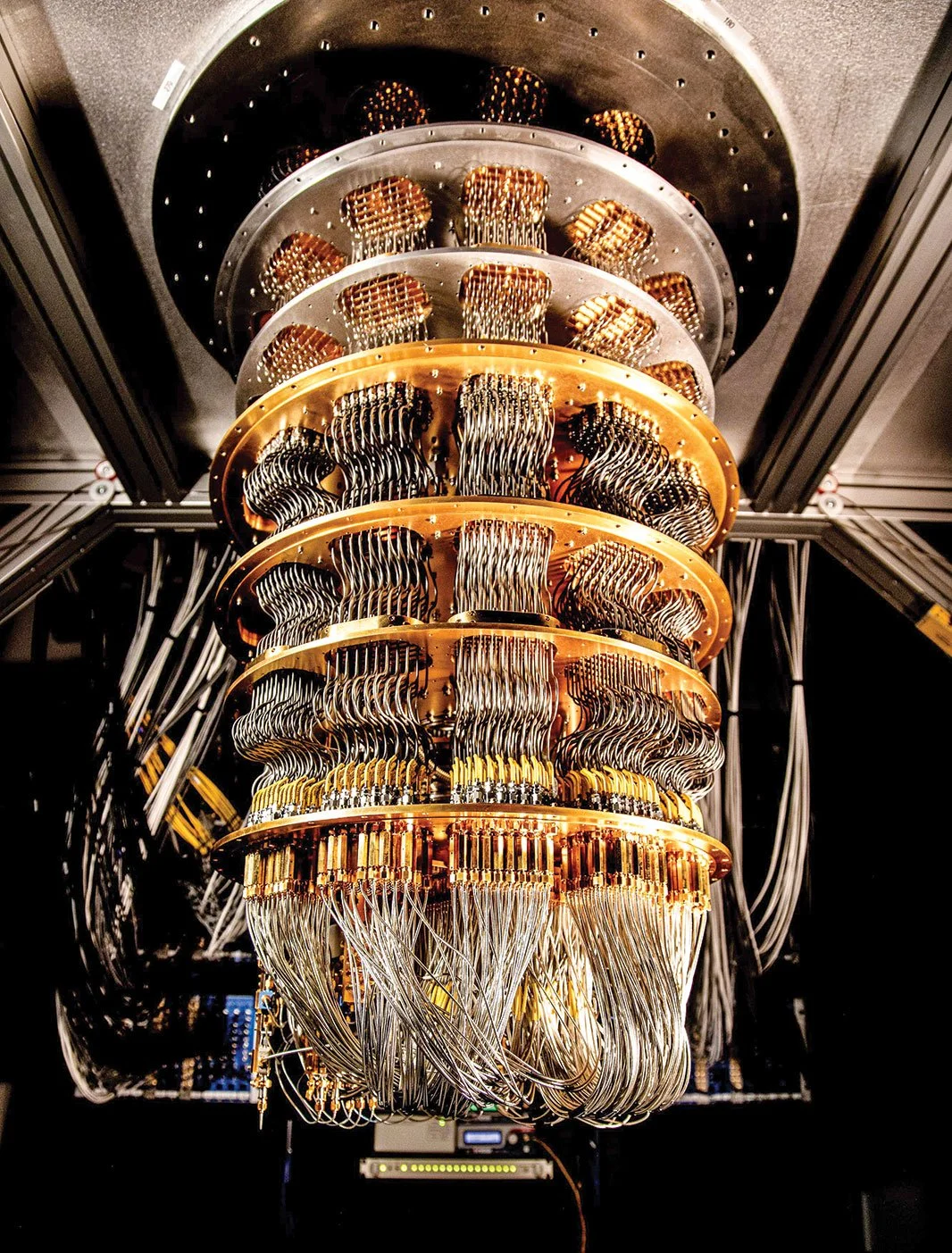

Físicos han logrado mantener un sistema de más de 3.000 cúbits en operación continua durante más de dos horas, diez veces más que el umbral mítico de los 300 cúbits y, sobre todo, sin necesidad de reinicios periódicos. Sobre esta líneas, un criostato cubierto de cables de microondas enfría el chip cuántico de Google hasta acercarlo al cero absoluto. Cortesía: Erik Lucero / Google Quantum AI

Durante años, la promesa de la computación cuántica ha flotado entre los científicos como un horizonte lejano: máquinas capaces de realizar en segundos cálculos que ningún superordenador clásico lograría completar en la vida del universo. Los defensores de esta tecnología recuerdan a menudo un ejemplo llamativo: con apenas 300 cúbits, un ordenador cuántico podría almacenar más información de la que contienen todas las partículas del cosmos observable.

Ahora, un equipo de la Universidad de Harvard y el Instituto Tecnológico de Massachusetts (MIT) acaba de dar un salto que cambia las reglas del juego. En un trabajo publicado en la revista Nature, los físicos han logrado mantener un sistema de más de 3.000 cúbits en operación continua durante más de dos horas. Es diez veces más grande que el umbral mítico de los 300 cúbits y, sobre todo, se trata del primer ordenador cuántico capaz de funcionar sin necesidad de efectuar reinicios de forma periódica.

«Demostramos la operación continua con un sistema de 3.000 cúbits», explica Mikhail Lukin, profesor de Harvard y uno de los líderes del proyecto, en Harvard Gazette. Y añade—: Pero también está claro que este enfoque funcionará con números mucho mayores».

De la fragilidad al modo continuo

Hasta ahora, la mayoría de prototipos cuánticos funcionaban en modo pulsado: se preparaban los qcúbits, se ejecutaban algunas operaciones durante unos segundos o minutos y después el sistema debía reiniciarse, porque los átomos se perdían o la coherencia se desmoronaba. Este fenómeno de pérdida de átomos ha sido una pesadilla para la comunidad informática.

«Lo que mostramos es una forma de insertar nuevos átomos a medida que se van perdiendo, sin destruir la información ya almacenada —destaca en la citada gaceta Elias Trapp, estudiante de doctorado en la Facultad de Artes y Ciencias Kenneth C. Griffin y coautor del estudio—. Eso resuelve de verdad este cuello de botella fundamental».

El avance se apoya en un diseño experimental ingenioso: una especie de cinta transportadora de átomos ultrafríos que nutre sin cesar al procesador. Dos cintas transortadoras de luz —redes ópticas formadas por láseres— trasladan nubes de millones de átomos de rubidio desde una cámara de enfriamiento hasta la región central, la zona de ciencia. Allí, haces láser en forma de pinzas ópticas atrapan a los átomos uno a uno y los organizan en cuadrículas perfectamente ordenadas.

Con este sistema, los físicos lograron una tasa de reposición récord: 300.000 átomos por segundo convertidos en 30.000 cúbits preparados cada segundo. Es como tener un flujo constante de fichas que reemplazan a las que se desgastan en una partida infinita.

Mantener la coherencia cuántica intacta

El reto no era solo reponer átomos, sino hacerlo sin perturbar los cúbits vecinos que ya estaban calculando. Para ello, los investigadores desarrollaron un sofisticado blindaje óptico: desplazaron la frecuencia de la luz de enfriamiento para que no afectara a los átomos en uso, y aplicaron secuencias de corrección llamadas desacoplamiento dinámico. El resultado: los qubits conservaron su coherencia incluso mientras el sistema se recargaba en paralelo.

En los experimentos, el equipo mantuvo 3.000 cúbits funcionando de manera estable durante más de 120 minutos, mucho más allá de la vida natural de una trampa óptica individual (unos sesenta segundos). En ese tiempo, circularon más de 50 millones de átomos por la máquina, una auténtica demostración de resistencia.

«Esta nueva operación continua, que permite reemplazar qubits perdidos sin interrumpir el sistema, puede ser en la práctica más importante que alcanzar un número concreto de cúbits» subraya Lukin.

Una fábrica de cúbits frente a la competencia

El logro de Harvard y el MIT llega en un momento de intensa competencia internacional. Apenas unos días antes, un grupo del Caltech anunció un sistema de 6.100 cúbits en pinzas ópticas. Pero había una diferencia crucial: su procesador solo pudo funcionar durante trece segundos antes de colapsar. El contraste pone en perspectiva la hazaña de los 3.000 cúbits continuos durante horas.

«Lo que realmente nos hace destacar es la combinación de tres cosas —la escala, preservar la información cuántica y hacer que todo el proceso sea lo suficientemente rápido para ser útil», señala Neng-Chun Chiu, autor principal del estudio y estudiante de doctorado en Harvard, en la Harvard Gazette.

La colaboración estuvo encabezada por Lukin, Markus Greiner (Harvard) y Vladan Vuletic (MIT), e incluyó también a la startup QuEra Computing, que surgió de los laboratorios Harvard-MIT. QuEra es uno de los actores más prometedores del sector, con el objetivo declarado de construir ordenadores cuánticos comerciales basados en átomos neutros.

Por qué importa: de la teoría a la práctica

En los ordenadores clásicos, doblar el número de bits dobla la capacidad de procesamiento. En los cuánticos, cada cúbit adicional multiplica exponencialmente la potencia gracias a la superposición y al entrelazamiento. Por eso, pasar de cientos a miles no es un simple salto aritmético, sino un cambio cualitativo.

Hasta ahora, la limitación no era tanto la cantidad como la persistencia. Un ordenador cuántico capaz de ejecutar miles de millones de operaciones de manera continuada, como sueñan los teóricos, necesitaba una arquitectura que evitara los constantes reinicios. Eso es lo que por primera vez se ha mostrado de forma convincente.

«Este sueño está ahora por primera vez a nuestro alcance directo —celebra Lukin—. Se puede ver un camino muy claro hacia ordenadores cuánticos que funcionen durante días, ejecutando miles de millones de operaciones».

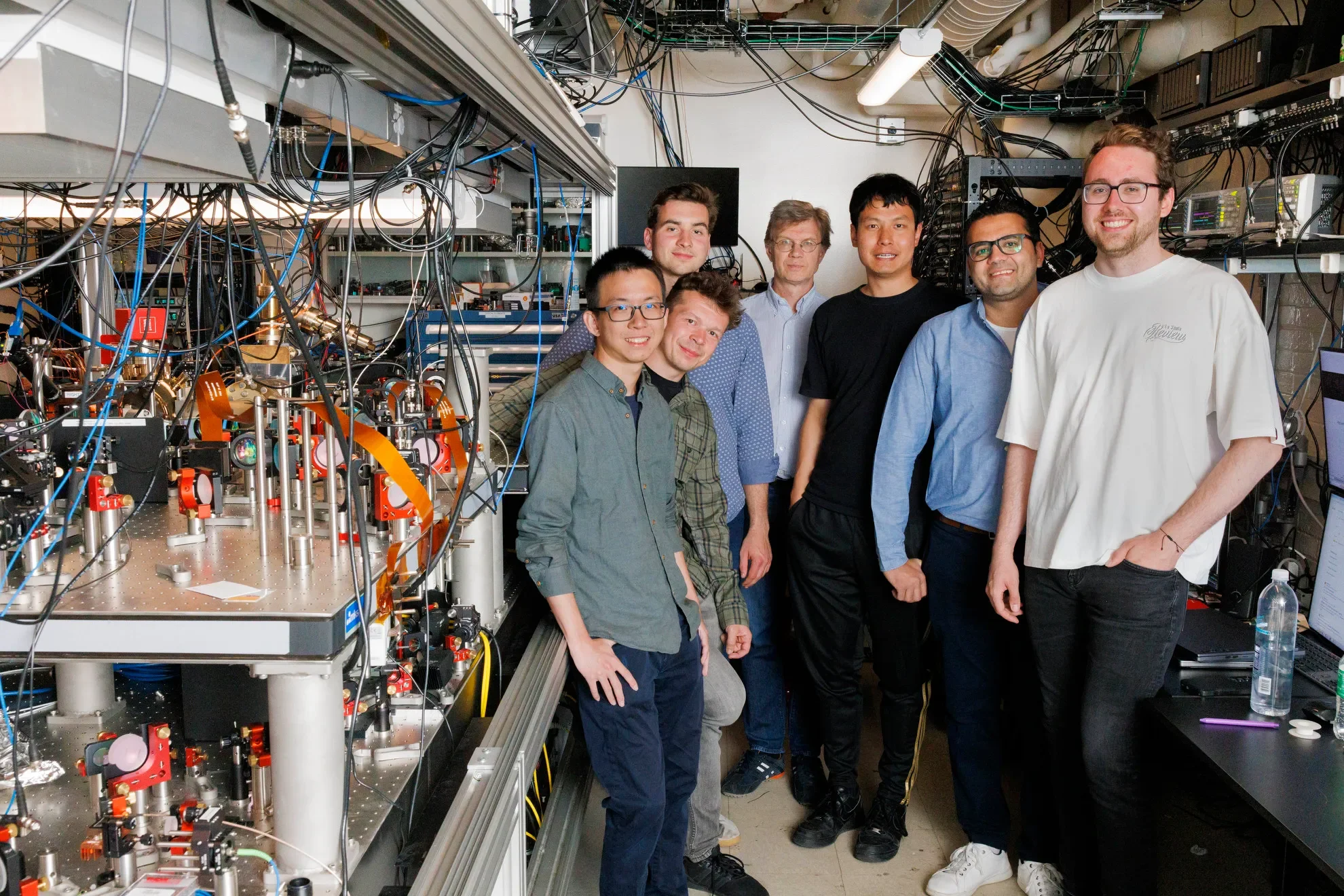

El equipo de investigadores Neng-Chun Chiu (izquierda), Simon Hollerith, Luke Stewart, Mikhail Lukin, Jinen (Tim) Guo, Mohamed Abobeih y Elias Trapp, protagonistas del avance en computación cuántica de Harvard y MIT. Cortesía: Veasey Conway / Harvard Staff Photographer

Qué aplicaciones abre este avance

El impacto de esta tecnología toca varios ámbitos de la revolución cuántica:

✅ Computación tolerante a fallos: los esquemas de corrección de errores requieren reemplazar cúbits defectuosos constantemente. El sistema de Harvard-MIT demuestra que es factible hacerlo sin interrumpir el cálculo. Con mejoras en la fidelidad de las puertas cuánticas y mayores tasas de recarga, sería posible mantener procesadores de decenas de miles de qubits físicos y cientos de qubits lógicos estables.

✅ Relojes atómicos y metrología: eliminar los tiempos muertos entre ciclos mejorará la precisión de los relojes ópticos y reducirá el ruido de medición. Esto se traduce en sistemas de navegación, geodesia y sincronización de redes mucho más precisos.

✅ Redes cuánticas: una corriente inagotable de cúbits facilita la generación rápida de entrelazamiento remoto, esencial para una futura internet cuántica.

✅ Sensores de precisión: cCampos gravitatorios, magnéticos o eléctricos podrían medirse con resoluciones imposibles para la tecnología actual.

Una arquitectura reconfigurable y viva

El anuncio de los 3.000 cúbits continuos coincidió con la publicación de otros dos estudios del mismo grupo. En uno, los físicos demostraron un procesador cuántico reconfigurable en tiempo real, capaz de cambiar la conectividad entre cúbits durante el cálculo.

«Podemos literalmente reconfigurar el ordenador cuántico mientras está funcionando —dice Lukin—. Básicamente, el sistema se convierte en un organismo vivo».

En otro trabajo, presentaron nuevas técnicas de corrección de errores, lo que refuerza la visión de un futuro en el que los ordenadores cuánticos ejecuten operaciones sin límite de profundidad. Juntos, estos avances componen un paquete que, en palabras del propio Lukin, muestra «un camino muy directo hacia la realización de procesadores cuánticos útiles».

Perspectivas y próximos pasos

Aunque el logro es impresionante, el camino hacia un ordenador cuántico de uso general aún tiene obstáculos. Los investigadores reconocen la necesidad, entre otras cosas, de:

✅ Acelerar la preparación de cúbits mediante algoritmos de inteligencia artificial que organicen las pinzas ópticas en tiempo real.

✅ Escalar las zonas de preparación y almacenamiento, multiplicando por diez o más la capacidad.

✅ Automatizar la estabilidad óptica, de modo que el sistema pueda funcionar sin intervención humana durante días enteros.

El propio Lukin se muestra optimista: con mejoras técnicas inmediatas —láseres más potentes, moduladores más eficientes y algoritmos más rápidos de reordenamiento—, la tasa de recarga podría multiplicarse por cinco. Eso abriría la puerta a ordenadores cuánticos con decenas de miles de qubits en operación continua.

Un cambio cultural en la cuántica

Más allá de la cifra récord, el experimento marca un cambio cultural en la disciplina. Hasta ahora, los físicos trabajaban con sistemas efímeros, como maquetas que había que reiniciar constantemente. Con esta demostración, nace la idea de las máquinas cuánticas persistentes, comparables a los ordenadores clásicos que permanecen encendidos indefinidamente mientras tengan suministro eléctrico.

El paso recuerda a la historia de la informática clásica: de válvulas frágiles y cortas de vida se pasó a transistores fiables y estables. Algo similar podría estar ocurriendo con las matrices de átomos neutros: su madurez técnica abre la posibilidad de ordenadores cuánticos útiles en la próxima década.

La carrera por la supremacía cuántica —ese momento en que un ordenador cuántico resuelva una tarea imposible para un clásico— está más reñida que nunca. Google apuesta por circuitos superconductores, IonQ y Quantinuum por iones atrapados, y empresas emergentes exploran fotones. Los átomos neutros, como los usados en Harvard y el MIT, ganan terreno porque combinan escalabilidad y simplicidad relativa.

El logro de los 3.000 cúbits continuos muestra que los retos de estabilidad y escalado pueden superarse con creatividad experimental. Y, en palabras de los propios protagonistas, sugiere que la visión de ordenadores cuánticos ejecutando cálculos durante días sin detenerse ya no es un sueño lejano, sino una meta visible en el horizonte. ▪️

Preguntas & Respuestas: Cúbits y computación cuántica

📀 ¿Qué han logrado los científicos de Harvard y MIT en computación cuántica?

Han creado un ordenador cuántico de 3.000 cúbits capaz de operar de forma continua durante más de dos horas, superando el problema de la pérdida de átomos.

📀 ¿Por qué es importante mantener cúbits en operación continua?

Porque los reinicios limitaban los experimentos. Con este avance, los qubits pueden reponerse sin interrumpir el cálculo, allanando el camino a sistemas útiles a gran escala.

📀 ¿Qué aplicaciones prácticas tendrá este avance en computación cuántica?

Permite acercarse a ordenadores cuánticos tolerantes a fallos, relojes atómicos más precisos, sensores de alta resolución e incluso una futura internet cuántica.

📀 ¿Quiénes lideraron el proyecto del ordenador cuántico de 3.000 cúbits?

El equipo fue dirigido por Mikhail Lukin (Harvard), Markus Greiner (Harvard) y Vladan Vuletic (MIT), en colaboración con la empresa QuEra Computing.

📀 ¿Cómo se compara este resultado con otros récords recientes en computación cuántica?

El sistema de Caltech alcanzó 6.100 cúbits, pero solo funcionó trece segundos. El de Harvard-MIT logró menos cúbits, pero con operación continua durante horas.

Información facilitada por The Harvard Gazette

Fuente: Zhou, H., Zhao, C., Cain, M. et al. Low-overhead transversal fault tolerance for universal quantum computation. Nature (2025). DOI: https://doi.org/10.1038/s41586-025-09543-5