La primera simulación realista de la Vía Láctea: inteligencia artificial, supercomputación extrema y 100.000 millones de estrellas modeladas una a una

La astrofísica ha cruzado un umbral histórico: por primera vez, una Vía Láctea completa ha sido recreada estrella a estrella gracias a la unión de la IA y la supercomputación. Un experimento pionero que revela cómo nació y evolucionó nuestra galaxia con una precisión sin precedentes.

Por Enrique Coperías

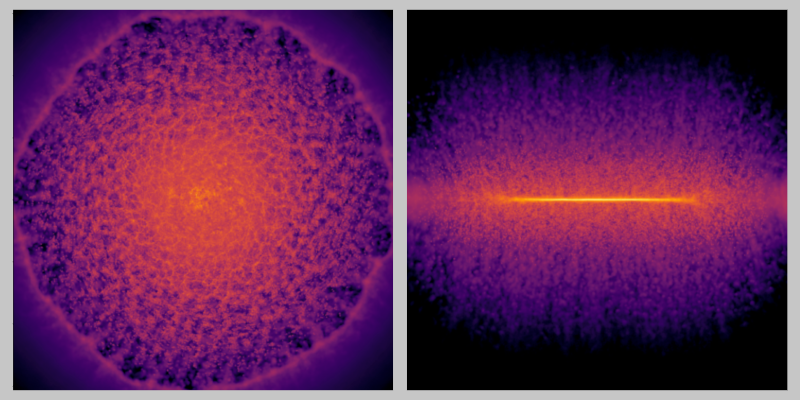

Instantáneas frontal (izquierda) y lateral (derecha) del disco galáctico de gas tras una explosión de supernova, generadas por el modelo de aprendizaje profundo empleado en la simulación. Crédito: RIKEN.

Recrear la Vía Láctea completa, con sus cien mil millones de estrellas y su compleja vida interna de explosiones, choques, turbulencias y ciclos químicos, ha sido durante décadas uno de los grandes sueños —y frustraciones— de la astrofísica computacional.

El problema no era conceptual, sino tecnológico: incluso los superordenadores más potentes se estrellaban una y otra vez contra un muro de limitaciones físicas y numéricas. El cuello de botella era siempre el mismo: fenómenos muy rápidos y muy pequeños, como las explosiones de supernovas, obligaban a detener continuamente la simulación para recalcular la evolución del gas a intervalos ínfimos. Cada miniexplosión en un rincón de la galaxia paralizaba las máquinas y devoraba horas de cálculo.

Este año, un equipo internacional de astrofísicos y especialistas en computación ha conseguido por primera vez superar ese muro. Y lo ha hecho con una combinación inesperada: la potencia bruta del superordenador japonés Fugaku —uno de los más rápidos del mundo desarrollado por Fujitsu— y un modelo de inteligencia artificial (IA) diseñado para encargarse de esas pequeñas regiones problemáticas donde estallan las supernovas.

Una supercomputadora petaescala

El resultado lo podemos clasificar como histórico, ya que es la primera simulación de la Vía Láctea resuelta estrella a estrella, con 300.000 millones de partículas, ejecutada sobre 7,1 millones de núcleos de CPU, y capaz de reproducir los ciclos internos de nuestra galaxia con un nivel de detalle sin precedentes.

Recordemos que los núcleos de CPU mencionados en la simulación son unidades de cálculo independientes dentro de cada procesador, auténticos motores capaces de ejecutar instrucciones por sí mismos. En una supercomputadora petaescala como Fugaku, millones de estos núcleos trabajan en paralelo, repartiendo entre sí los cálculos necesarios para modelar la evolución de una galaxia completa. Cuantos más núcleos actúan al mismo tiempo, mayor es la capacidad de procesar fenómenos complejos como supernovas, turbulencias de gas o la dinámica del disco galáctico.

🗣️ «Creo que integrar la inteligencia artificial con la computación de alto rendimiento marca un cambio fundamental en la manera en que abordamos problemas multiescala y multifísicos en las ciencias computacionales», confiesa Keiya Hirashima, responsable del proyecto en el centro iTHEMS del gran instituto de investigación RIKEN, en Japón, e investigador principal del estudio.

Por qué simular la Vía Láctea estrella a estrella era casi imposible

Hasta ahora, todas las grandes simulaciones de galaxias habían tenido que elegir entre dos sacrificios: o bien se representaba la Vía Láctea con muy poca resolución, esto es cada estrella en la simulación era en realidad un paquete de cientos o miles, o bien se simulaban galaxias mucho más pequeñas, las llamadas galaxias enanas, para poder alcanzar una resolución estelar realista.

Las limitaciones no eran por falta de máquinas. Incluso los mejores códigos utilizados por la comunidad, como GIZMO, AREPO y GADGET, nombres míticos en la astrofísica computacional, quedaban atrapados en la misma trampa: las escalas físicas dentro de una galaxia difieren por factores de un millón.

Mientras el halo de materia oscura se extiende hasta 200.000 años luz, la onda expansiva de una supernova evoluciona en apenas unos años y en unas pocas decenas de parsecs; un persec es una unidad de distancia astronómica equivalente a 3,26 años luz. Esa diferencia obliga a usar intervalos de tiempo diminutos cada vez que estalla una supernova, y con miles de millones de partículas implicadas, la simulación se vuelve inmanejable.

Por eso el máximo alcanzado hasta ahora rondaba el umbral de los mil millones de partículas. Era una barrera técnica y conceptual: para reproducir la Vía Láctea estrella a estrella, hacía falta al menos cien veces más.

La innovación clave: un modelo de IA que «sustituye» a la física local de las supernovas

Aquí es donde entra la innovación clave del trabajo: un modelo de aprendizaje profundo, en concreto una red neuronal 3D tipo U-Net, entrenado para prever cómo evoluciona el gas alrededor de una supernova durante los primeros 100.000 años tras la explosión. Esta es la fase más problemática, la que exige timesteps (pasos de tiempo) minúsculos y ralentiza toda la simulación. La red neuronal aprende ese comportamiento a partir de cientos de simulaciones locales de supernovas realizadas previamente a alta resolución.

La propuesta es ingenios, pues cuando en la simulación global estalla una estrella, el superordenador extrae únicamente la caja de gas alrededor de la supernova, se la envía a un nodo especial, y allí la IA predice cómo evolucionará ese volumen. Mientras tanto, el resto de los nodos —la inmensa mayoría— siguen avanzando la simulación general sin detenerse. Cuando la predicción está lista, se reinserta en la simulación.

El truco permite algo que antes era impensable: usar un único paso de tiempo global para toda la galaxia, sin que cada supernova obligue a ralentizarlo todo. Es, en esencia, convertir millones de microproblemas rígidos y lentos en un proceso paralelo, fluido y precomputado por la IA.

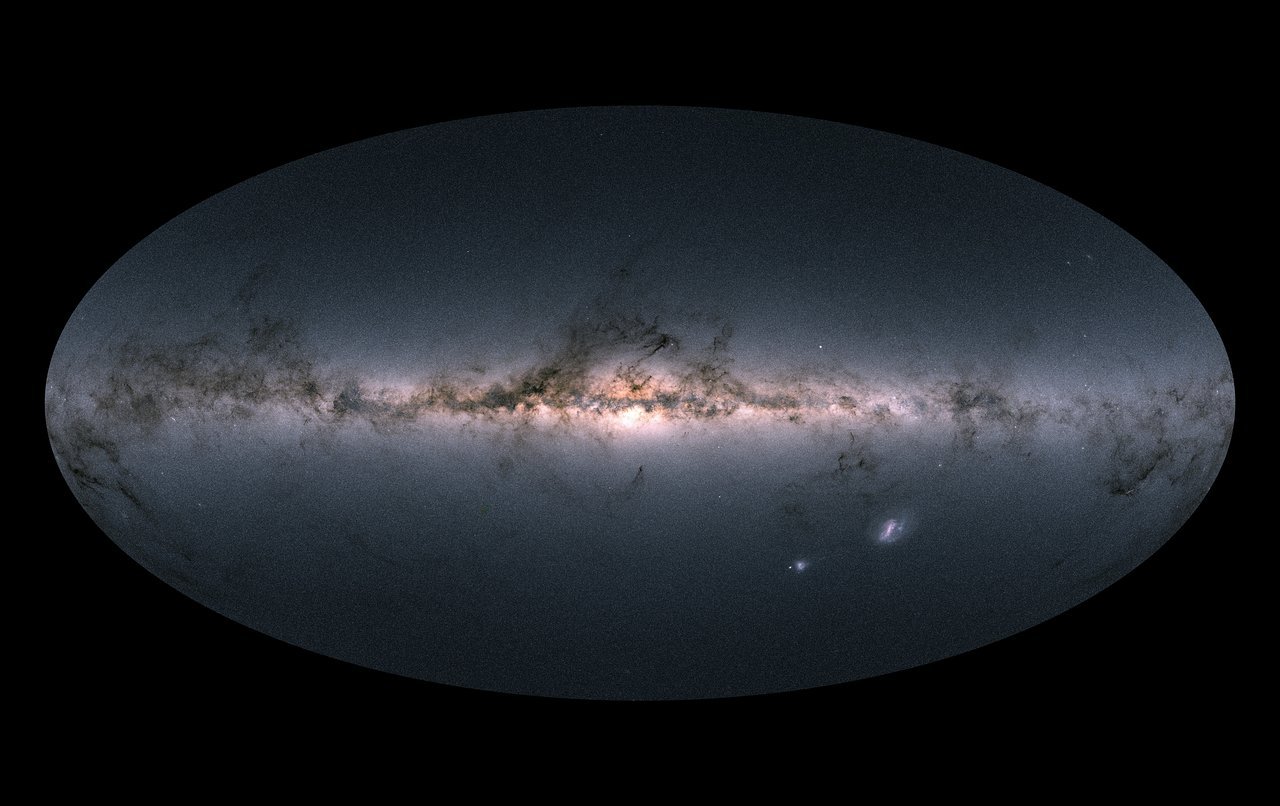

Vista completa del cielo obtenida por la misión Gaia de la ESA, basada en las posiciones y movimientos de casi 1.700 millones de estrellas de la Vía Láctea. Este catálogo, el más preciso jamás creado, ha revolucionado el estudio del origen y la evolución de nuestra galaxia. Crédito: ESA/Gaia/DPAC, CC BY-SA 3.0 IGO.

Un logro técnico sin precedentes: 300.000 millones de partículas y 7 millones de núcleos de CPU

Con esta estrategia, los investigadores alcanzaron números que hasta hace poco habrían parecido ciencia ficción. Usando 148.900 nodos del superordenador Fugaku, equivalentes a 7.147.200 núcleos de CPU, lograron simular una Vía Láctea completa con:

✅ 1,8 × 10¹¹ partículas de materia oscura.

✅ 7,2 × 10¹⁰ partículas de estrellas.

✅ 4,9 × 10¹⁰ partículas de gas.

✅ Resolución estelar de 0,75 masas solares, prácticamente la masa del Sol.

En total, hablamos de casi 300.000 millones de partículas, más de quinientas veces el límite previo.

La simulación no solo es grande: es rápida. Con la ayuda de la IA, cada paso temporal tarda apenas unos veinte segundos. Simular un millón de años de historia galáctica lleva menos de tres horas. En comparación, una simulación convencional de mismo tamaño tardaría, según los autores, 113 veces más, y ni siquiera sería factible en máquinas actuales.

Qué permite estudiar ahora esta simulación (y por qué es un salto científico)

Lo que hace extraordinaria esta simulación no es solo su tamaño, sino su capacidad científica. Por primera vez se puede estudiar la Vía Láctea en alta definición, estrella a estrella, e investigar fenómenos como los que siguen:

1️⃣ La formación del disco galáctico y sus brazos espirales. La simulación reproduce el patrón espiral con resolución estelar real, revelando cómo se forman, se mantienen y evolucionan estas estructuras.

2️⃣ El ciclo químico del gas y producción de elementos. Cada supernova se modela de forma individual, lo que permite seguir en detalle la dispersión de metales —oxígeno, carbono, hierro— a través del medio interestelar.

3️⃣ La interacción entre estrellas y materia oscura. El modelo traza cómo la materia oscura influye en la formación del disco, el halo y las estructuras radiales.

4️⃣ Las comparaciones directas con datos de telescopios como Gaia. Por primera vez, una simulación tiene suficiente resolución para compararse punto por punto con los catálogos estelares reales.

5️⃣ Las turbulencia del gas y nacimiento de nuevas estrellas. Reproduce la complejísima red de filamentos y nubes moleculares donde se forman estrellas jóvenes.

6️⃣ La morfología tridimensional del medio interestelar, incluida su estructura filamentosa.

🗣️ «Este logro también demuestra que las simulaciones aceleradas por IA pueden ir más allá del reconocimiento de patrones y convertirse en una verdadera herramienta para el descubrimiento científico, ayudándonos a rastrear cómo surgieron, dentro de nuestra galaxia, los elementos que dieron origen a la vida misma», subraya Hirashima.

Un hito también para la ingeniería computacional

El logro no es solo astrofísico: también representa una proeza de ingeniería informática. La simulación utiliza dos herramientas clave:

✅ La FDPS, una biblioteca capaz de paralelizar cálculos de interacción gravitatoria y de fluidos a escala masiva.

✅ La PIKG, un generador automático de kernels —pequeños bloques de código muy optimizados que ejecutan una operación específica de forma extremadamente rápida— altamente optimizados para cada arquitectura, desde CPUs x86 hasta GPU Hopper de NVIDIA.

El código escala casi linealmente hasta 150.000 nodos, algo muy raro en computación de alto rendimiento, donde las comunicaciones internas suelen ahogar cualquier intento de escalar más allá de unos pocos miles de procesadores.

Impacto más allá de la astrofísica: del clima al modelado del océano

Como resaltan Hirashima y sus colegas de la Universidad de Tokio (Japón) y de la Universidad de Barcelona (España) en el estudio, que aparece publicado en la ACM Digital Library, esta técnica no es exclusiva de la astrofísica. Cualquier problema físico donde fenómenos locales muy rápidos obliguen a usar timesteps diminutos podría beneficiarse de un modelo de IA que actúe como sustituto (surrogate model) de esas regiones:

✅ Modelos climáticos globales, con tormentas que arruinan la escala temporal.

✅ Simulaciones atmosféricas.

✅ Turbulencia en ingeniería aeronáutica.

✅ Discos de acreción alrededor de agujeros negros.

✅ Formación de grandes estructuras cosmológicas.

La idea es siempre la misma: dejar que la física controle el gran cuadro y que la IA resuelva los detalles microscópicos que tradicionalmente ralentizan todo el cálculo.

Una nueva era para simular el universo con precisión estelar

Lo conseguido por este equipo marca un antes y un después. Durante décadas, los astrofísicos tuvieron que elegir entre precisión o tamaño. Hoy, por primera vez, es posible tener ambas: una Vía Láctea completa simulada con resolución estelar. Esto abre una nueva dimensión para la investigación: probar hipótesis sobre la historia de nuestra galaxia, comparar con observaciones, explorar escenarios alternativos y estudiar procesos que nunca antes habían sido accesibles con tanto detalle.

Si la astronomía del siglo XXI se caracteriza por el big data, esta simulación añade una nueva capa: el big simulation, en el que el universo no solo se observa, sino que se recrea con fidelidad casi anatómica.

Y todo gracias a una alianza insólita entre la computación extrema y la inteligencia artificial. Una alianza que, como demuestran estos resultados, puede transformar la forma en que exploramos y entendemos el cosmos. ▪️

Información facilitada por el RIKEN

Fuente: Hirashima, Keiya and Fujii, Michiko S and Saitoh, Takayuki R and Harada, Naoto and Nomura, Kentaro and Yoshikawa, Kohji and Hirai, Yutaka and Asano, Tetsuro and Moriwaki, Kana and Iwasawa, Masaki and Okamoto, Takashi and Makino, Junichiro. The First Star-by-star $N$-body/Hydrodynamics Simulation of Our Galaxy Coupling with a Surrogate Model. ACM Digital Library (2025). DOI: 10.1145/3712285.3759866