Procesador cuántico de silicio: cómo detecta errores sin destruir el entrelazamiento y acerca la computación cuántica real

Un nuevo experimento demuestra que un procesador cuántico de silicio puede detectar errores sin destruir la frágil información entrelazada que hace posible la computación cuántica. El avance acerca la creación de ordenadores cuánticos reales, capaces de funcionar de forma fiable y a gran escala.

Por Enrique Coperías, periodista científico

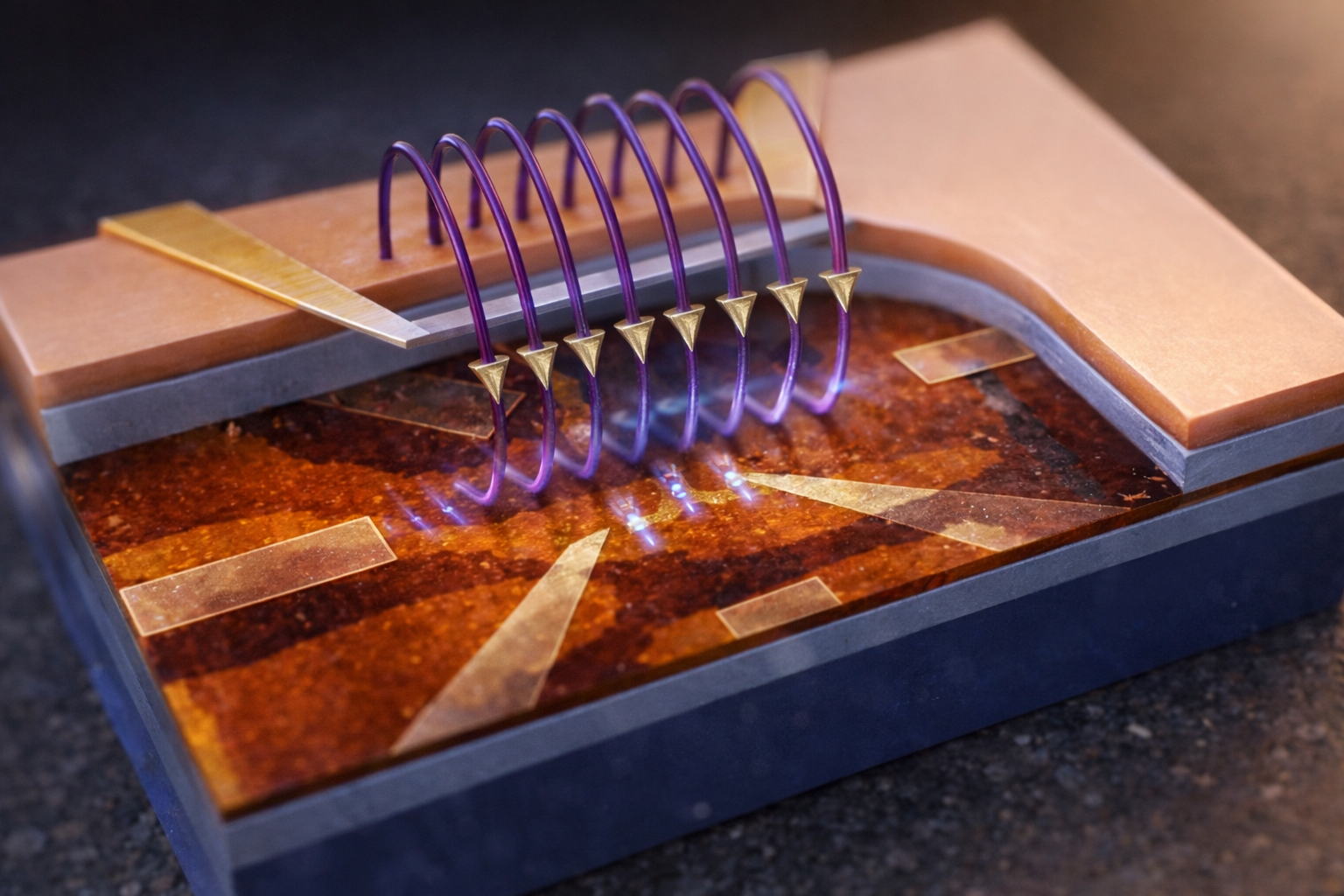

Representación realista de un procesador cuántico de silicio en el que varios cúbits son controlados mediante microondas para detectar errores sin destruir el entrelazamiento, un paso clave hacia la computación cuántica tolerante a fallos. Crédito: IA-DALL-E-Rexmolón Producciones

El día en que los ordenadores cuánticos dejen de equivocarse —o al menos aprendan a hacerlo sin perder información— estará más cerca de convertirse en realidad.

Un equipo de investigadores del Instituto de Ciencia e Ingeniería Cuántica y de la Academia Cuántica Internacional de Shenzhen, en China, ha logrado detectar errores en un procesador cuántico de silicio sin destruir el delicado entrelazamiento cuántico que sostiene la información cuántica, un paso técnico crucial para que esta tecnología pueda escalar más allá del laboratorio.

El avance, descrito en un artículo científico en la revista Nature Electronics y dirigido por los investigadores Guanyong Wang, Guangchong Hu, Yu He y Dapeng Yu, demuestra por primera vez en un dispositivo de silicio la detección de errores cuánticos arbitrarios de un solo cúbit mientras se preserva el entrelazamiento entre varios de ellos, una de las propiedades más frágiles y valiosas de la computación cuántica.

¿Qué es el entrelazamiento cuántico?

El entrelazamiento cuántico es un fenómeno por el que dos o más cúbits quedan vinculados de tal forma que el estado de uno depende instantáneamente del estado del otro, incluso si están separados físicamente.

En computación cuántica, este vínculo permite que la información se distribuya entre varios cúbits y se procese de manera conjunta, multiplicando la capacidad de cálculo frente a los ordenadores clásicos.

Sin embargo, el entrelazamiento es extremadamente frágil: cualquier interacción con el entorno puede romperlo y destruir la información cuántica, por lo que preservarlo mientras se detectan y corrigen errores es uno de los mayores desafíos tecnológicos del campo.

Qué es un procesador cuántico de silicio y por qué es importante

La computación cuántica promete resolver problemas que hoy están fuera del alcance de los superordenadores clásicos, desde la simulación de materiales y moléculas hasta la optimización logística y el diseño de nuevos fármacos. Sin embargo, su talón de Aquiles es el error. Los cúbits —las unidades básicas de información cuántica— son extremadamente sensibles al entorno. Vibraciones, defectos del material o fluctuaciones electromagnéticas pueden alterar su estado y arruinar un cálculo.

Para que un ordenador cuántico sea útil, no basta con fabricar cúbits: hay que controlarlos, detectar sus fallos y corregirlos. El objetivo final es la llamada computación cuántica tolerante a fallos, un sistema capaz de realizar operaciones complejas pese a que los errores físicos sigan ocurriendo a pequeña escala.

Ahí es donde entra el nuevo experimento. Los ingenieros chinos han utilizado un procesador cuántico basado en silicio —el mismo material que domina la industria electrónica— para demostrar que se pueden detectar errores sin destruir la información cuántica almacenada en un estado entrelazado.

Un procesador cuántico dentro del silicio

El dispositivo se construyó a partir de átomos donadores incrustados en silicio ultrapuro. Cada átomo contiene núcleos con espines que pueden actuar como cúbits, acompañados por un electrón que funciona como un cúbit auxiliar y mediador de las interacciones. El sistema empleado incluía cuatro cúbits nucleares y un cúbit electrónico.

A temperaturas cercanas al cero absoluto —en torno a los −273 ºC— y bajo un intenso campo magnético, los investigadores manipularon los espines mediante pulsos de microondas y radiofrecuencia. De esta forma lograron controlar las operaciones cuánticas y generar estados entrelazados entre los cúbits nucleares.

Antes de intentar detectar errores, el equipo tuvo que demostrar que su procesador cuántico podía generar entrelazamiento fiable. Crearon estados de Bell —el tipo más simple de entrelazamiento cuántico entre dos cúbits— y posteriormente un estado GHZ de cuatro cúbits, una forma más compleja de entrelazamiento colectivo. La fidelidad del estado GHZ alcanzó el 88,5 %, una cifra notable en un sistema sólido de este tipo.

Este paso era imprescindible: si el entrelazamiento cuántico no se genera con suficiente precisión, cualquier intento de corrección de errores cuánticos carece de sentido.

Cómo detectar errores cuánticos sin destruir la información

En la computación clásica, detectar errores es sencillo: basta con comprobar si un bit ha cambiado. En la computación cuántica, el problema es más delicado. Medir directamente un cúbit puede colapsar su estado y destruir la información cuántica que se pretende proteger.

La solución pasa por medir propiedades colectivas de varios cúbits —los llamados estabilizadores cuánticos— que revelan si ha ocurrido un error sin leer directamente el estado lógico. Este principio es la base de los códigos de corrección de errores cuánticos, como el famoso código de superficie, que distribuye la información de un cúbit lógico en muchos cúbits físicos organizados en una red bidimensional. Mediante mediciones indirectas y repetidas, este permite detectar y corregir errores sin destruir la información cuántica, y es uno de los esquemas más prometedores para construir ordenadores cuánticos tolerantes a fallos.

El experimento implementó una versión mínima de este enfoque utilizando cuatro cúbits:

✅ Dos almacenaban la información cuántica en un estado entrelazado.

✅ Dos actuaban como auxiliares para detectar errores.

Mediante un circuito cuántico específico, el sistema podía identificar si se había producido un error de fase, un error de inversión de bit o una combinación de ambos.

Los resultados mostraron que el dispositivo detectaba con éxito errores cuánticos arbitrarios de un solo cúbit. Además, la detección se realizaba sin destruir el entrelazamiento original: tras identificar el error, los investigadores podían reconstruir el estado cuántico inicial mediante un procesamiento posterior de los datos.

Esta demostración es especialmente importante porque la detección de errores cuánticos debe realizarse de forma no destructiva. Si el propio proceso de detección destruyera la información cuántica, no serviría para sistemas reales.

Recuperar la información cuántica tras un error

Uno de los experimentos más reveladores consistió en introducir deliberadamente errores de decoherencia cuántica —el proceso por el cual un cúbit pierde su coherencia— y comprobar si la información entrelazada podía recuperarse. Que un cúbit pierda su coherencia significa que su estado cuántico se desordena al interactuar con el entorno y deja de comportarse de forma cuántica, perdiendo la información y las ventajas de cálculo que aporta.

Tras dejar evolucionar el sistema durante un tiempo en el que el entrelazamiento cuántico se degradaba, los investigadores aplicaron su protocolo de detección de errores cuánticos. Con los datos obtenidos, reconstruyeron el estado original mediante un método llamado actualización del marco de Pauli, una forma de corrección cuántica a nivel lógico sin modificar físicamente los cúbits.

El resultado fue que la fidelidad del estado entrelazado recuperado se mantuvo cercana a la inicial, incluso después de que la decoherencia hubiera reducido notablemente la calidad del estado sin corrección. En otras palabras: el sistema pudo detectar y compensar los errores manteniendo la información cuántica.

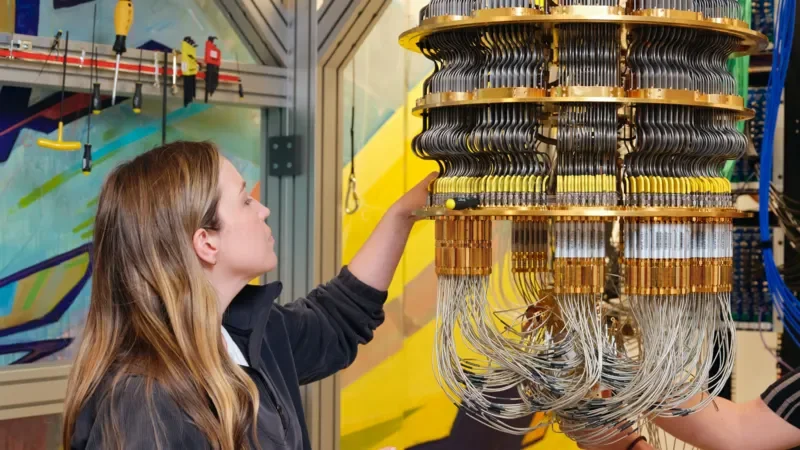

Una especialista ajusta un ordenador cuántico en un laboratorio: estos sistemas funcionan a temperaturas cercanas al cero absoluto y utilizan cúbits para realizar cálculos imposibles para la informática clásica. Cortesía: Google

Qué revela este experimento sobre el ruido cuántico

El estudio también permitió caracterizar el tipo de ruido cuántico presente en el procesador cuántico. Los investigadores observaron que el principal problema era la descoherencia de fase —un tipo de error que altera la fase del estado cuántico— mientras que la relajación energética era mucho menos frecuente.

Este sesgo en el tipo de errores podría ser una ventaja. Si se sabe que ciertos fallos son mucho más probables que otros, se pueden diseñar códigos de corrección cuántica adaptados específicamente a ese perfil. En el caso del silicio cuántico, la predominancia de errores de fase sugiere que los futuros códigos podrían optimizarse para ese tipo de ruido.

Otro resultado relevante fue la baja correlación del ruido entre cúbits. Si los errores de distintos cúbits están correlacionados, la corrección de errores cuánticos se vuelve mucho más difícil. El hecho de que el ruido sea en gran medida independiente en este sistema es una señal positiva para la escalabilidad cuántica.

Por qué el silicio es una plataforma clave para la computación cuántica

La computación cuántica se está desarrollando en varias plataformas: circuitos superconductores, iones atrapados, átomos neutros o fotónica cuántica, entre otras. El silicio cuántico ofrece una ventaja única: su compatibilidad con la tecnología CMOS utilizada en la industria de semiconductores.

En teoría, esto permitiría fabricar procesadores cuánticos utilizando técnicas similares a las de los chips actuales, facilitando la integración y la producción a gran escala. Sin embargo, los cúbits de silicio aún están en una fase relativamente temprana de desarrollo en comparación con otras plataformas.

Demostraciones como esta buscan cerrar esa brecha. Mostrar que el silicio puede implementar detección de errores cuánticos —un requisito esencial para sistemas a gran escala— refuerza su candidatura como base de futuros ordenadores cuánticos comerciales.

Hacia la computación cuántica tolerante a fallos

Aunque el avance es significativo, aún no representa un ordenador cuántico completamente tolerante a fallos. El experimento demuestra detección y corrección mediante procesamiento posterior, pero el objetivo final es realizar estas operaciones de forma continua y en tiempo real.

De forma resumida, los autores de este trabajo sostienen que para alcanzar ese nivel será necesario:

1️⃣ Aumentar el número de cúbits.

2️⃣ Mejorar los tiempos de coherencia.

3️⃣ Integrar detección y corrección automática.

4️⃣ Escalar la arquitectura a sistemas distribuidos.

Aun así, el estudio constituye una prueba de principio esencial: es posible detectar errores cuánticos en un procesador de silicio sin perder la información entrelazada.

Qué significa este avance para el futuro de los ordenadores cuánticos

La capacidad de detectar y corregir errores sin destruir la información es el requisito central para la computación cuántica práctica. Sin este mecanismo, los cálculos complejos se degradan rápidamente.

Este nuevo resultado demuestra que el silicio, material dominante de la electrónica moderna, puede convertirse también en la base de los futuros ordenadores cuánticos. Si se logra escalar esta tecnología, podría aprovechar la infraestructura industrial existente y acelerar la llegada de procesadores cuánticos comerciales.

En el camino hacia la computación cuántica real, cada avance en detección de errores, entrelazamiento estable y corrección cuántica reduce la distancia entre el laboratorio y las aplicaciones prácticas. Este experimento confirma que la computación cuántica tolerante a fallos ya no es solo un objetivo teórico, sino una tecnología en construcción.◾️(18-febrero-2026)

Fuente: Zhang, C., Li, C., Tian, Z. et al. Quantum error detection in a silicon quantum processor. Nature Electronics (2026). DOI: https://doi.org/10.1038/s41928-025-01557-1