¿Vale la pena tu televisor ultra HD? Los científicos fijan el límite de resolución del ojo humano

Un estudio de Cambridge y Meta redefine el límite de resolución del ojo humano: 94 píxeles por grado. El hallazgo podría transformar el diseño de televisores, móviles y visores de realidad virtual y aumentada.

Por Enrique Coperías

Ni el 4K ni el 8K son el final del camino. Investigadores británicos han medido con precisión cuántos píxeles puede ver el ojo humano, y su respuesta cambia todo lo que creíamos saber sobre la nitidez. Imagen generada con Copilot

Una de las mayores aspiraciones de la industria tecnológica es alcanzar la meta casi mítica de fabricar pantallas con tanta resolución que las imágenes resulten indistinguibles de la realidad. Los teléfonos, los televisores y los cascos de realidad virtual se anuncian con cifras cada vez más asombrosas —4K, 8K, 16K—, como si el número de píxeles fuera un pasaporte directo a la perfección visual.

Pero ¿dónde está realmente el límite? ¿Existe un punto a partir del cual nuestro ojo humano ya no puede distinguir más detalle?

Un equipo de investigadores de la Universidad de Cambridge y Meta acaba de ofrecer una respuesta más precisa que nunca. Su estudio, publicado en la revista Nature Communications, revisa las viejas estimaciones de la agudeza visual humana y concluye que vemos mejor de lo que se creía: hasta 94 píxeles por grado visual (ppd) en visión central, muy por encima del estándar de 60 ppd que durante décadas se ha dado por bueno.

En otras palabras, nuestra retina es más exigente de lo que la mayoría de los fabricantes de pantallas habían asumido.

La búsqueda del límite de la nitidez visual

El concepto que los autores investigan se conoce como resolución retinal. Esta es la densidad de detalle más alta a la que una imagen se percibe totalmente nítida, sin rastro de desenfoque. Más allá de ese punto, aumentar la resolución de la pantalla ya no aporta mejora perceptible alguna: el ojo ha alcanzado su techo.

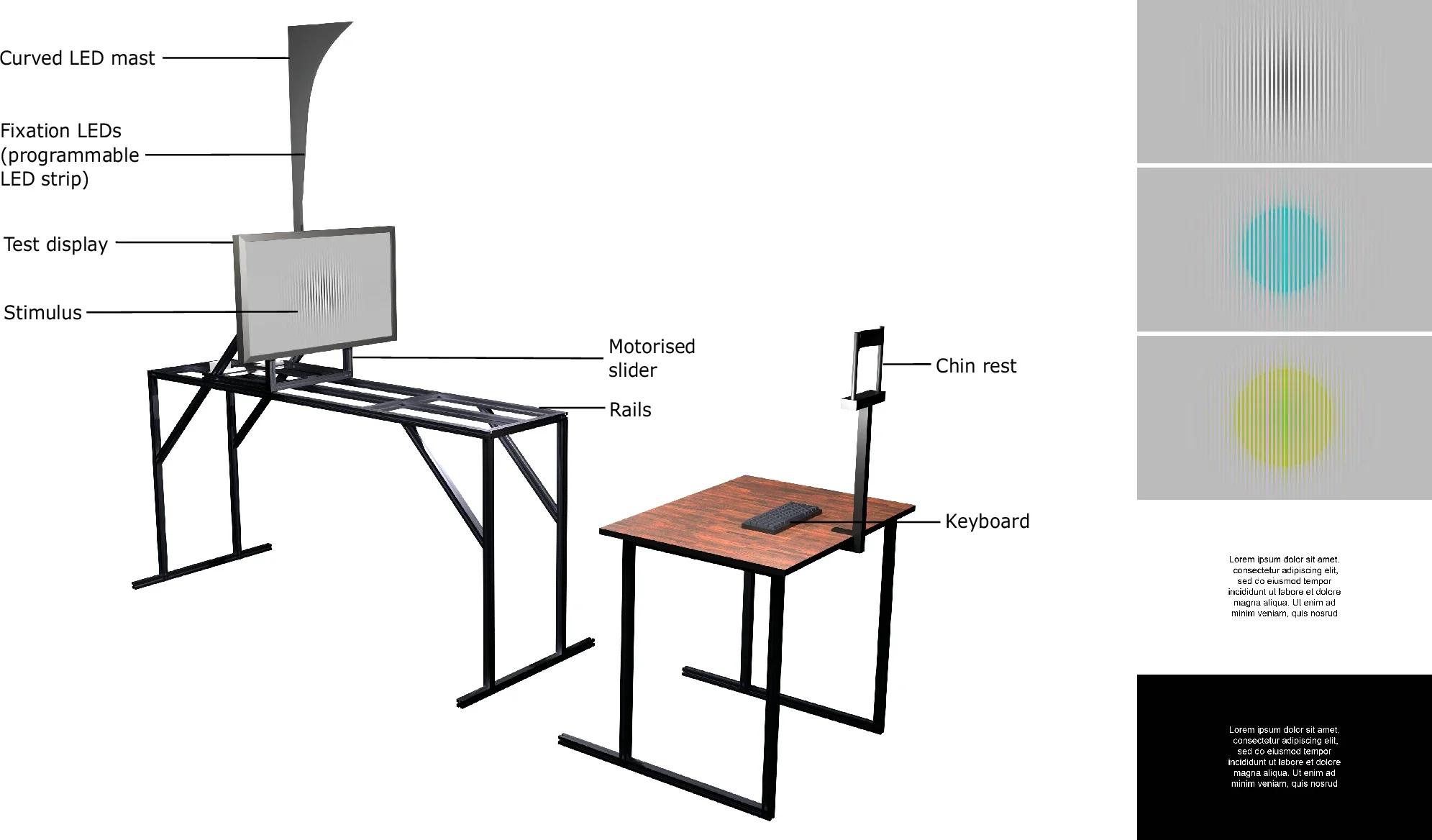

Medir ese límite, sin embargo, no es sencillo. Los estudios anteriores se basaban en estimaciones indirectas o en experimentos con rejillas de líneas o letras, con escaso control sobre la resolución efectiva. El equipo de Rafał Mantiuk, del Departamento de Ciencias de la Computación y Tecnología, en la Universidad de Cambridge, decidió enfrentarse al problema con un ingenioso montaje experimental: una pantalla deslizante controlada por un motor, capaz de acercarse o alejarse del observador con precisión milimétrica.

De este modo podían variar de forma continua la resolución angular (los píxeles por grado) sin alterar el contenido digital de la imagen, algo que las técnicas tradicionales no permitían.

🗣️ «A medida que se destinan grandes esfuerzos de ingeniería a mejorar la resolución de las pantallas de móviles, realidad aumentada y realidad virtual, es importante conocer la resolución máxima a partir de la cual las mejoras dejan de aportar un beneficio perceptible —explica la doctora Maliha Ashraf, primera autora del estudio y compañera de Mantiuk. Y añade—: Pero hasta ahora no existían estudios que midieran realmente qué es lo que el ojo humano puede ver y cuáles son las limitaciones de su percepción».

Los participantes, un grupo de dieciocho voluntarios con visión normal o corregida, observaron distintos patrones en blanco y negro y en combinaciones de color —rojo-verde y amarillo-violeta— a diferentes posiciones de la retina: en el centro (la fóvea) y en la periferia (10° y 20° de excentricidad). También se les mostraron textos, en modo claro y oscuro, para evaluar un tipo de estímulo más cotidiano.

Izquierda: recreación del montaje experimental, con una pantalla deslizante controlada por motor que se acerca o aleja del observador para variar la resolución en píxeles por grado (ppd). Derecha: ejemplos de los estímulos usados: rejillas en blanco y negro, rojo-verde y amarillo-violeta, y texto en modos claro y oscuro. Cortesía: Maliha Ashraf, Alexandre Chapiro & Rafał K. Mantiu

Resultados: el ojo ve más de lo que creíamos

El resultado más llamativo de la investigación fue que el límite foveal para patrones acromáticos (blanco y negro) alcanzó una media de 94 píxeles por grado, con algunos individuos llegando incluso a 120 ppd. Por comparación, el famoso Retina Display del iPad Pro alcanza unos 65 ppd vistos desde 35 centímetros: una cifra que se creía suficiente para que el ojo no distinguiera los píxeles. El nuevo estudio demuestra que no lo es.

La cifra de 60 ppd procede históricamente del estándar de visión 20/20, formulado por el oftalmólogo holandés Herman Snellen en el siglo XIX. Según esa convención, una persona con vista normal distingue detalles que subtenden un minuto de arco (1/60 de grado). Sin embargo, los investigadores de Cambridge muestran que el ojo humano joven y sano puede superar ampliamente ese valor.

«Esta medida se ha aceptado de forma generalizada, pero nadie se había sentado a medirla realmente en pantallas modernas, en lugar de usar un cartel de letras en la pared diseñado en el siglo XIX», critica Ashraf.

🗣️ «Si tu pantalla tiene más píxeles, es menos eficiente, cuesta más y necesita más potencia de procesamiento para funcionar —explica Mantiuk—. Queríamos averiguar el punto exacto a partir del cual deja de tener sentido seguir aumentando la resolución de una pantalla»

En palabras de este experto en percepción visual y tecnologías de imagen, «las pantallas comerciales están lejos de agotar la capacidad del ojo humano. Esto no significa que necesitemos televisores de 16K para todo, pero sí que el concepto de resolución retina se ha quedado corto».

Cómo sacarle los colores a la pantalla

Además de medir la agudeza en blanco y negro, el equipo exploró la resolución cromática, es decir, cuánto detalle podemos percibir en patrones de color puro. Los resultados revelan una fuerte asimetría entre los canales del sistema visual humano.

En la dirección rojo-verde, la resolución fue sorprendentemente alta: 89 ppd, casi igual que en blanco y negro. En cambio, los patrones amarillo-violeta apenas alcanzaron 53 ppd. Esto confirma que el canal oponente rojo-verde —el más sensible de los tres sistemas de color del ojo— puede manejar detalles finos casi tan bien como la luminancia, mientras que el canal azul-amarillo es mucho más limitado.

🗣️ «Nuestro cerebro en realidad no tiene una gran capacidad para percibir los detalles en color, y por eso observamos una caída tan pronunciada en las imágenes cromáticas, especialmente cuando se ven con la visión periférica —comenta Mantiuk. Y añade—: Nuestros ojos son básicamente sensores que no son tan buenos, pero el cerebro procesa esa información y la convierte en lo que cree que deberíamos estar viendo».

La pantalla Retina Display del iPad Pro, desarrollada por Apple, se hizo famosa por su alta densidad de píxeles, diseñada para que el ojo humano no pudiera distinguirlos individualmente a una distancia de uso normal. El resultado: imágenes y texto de nitidez impecable. Eso creíamos hasta ahora.

Esta diferencia tiene implicaciones prácticas. Los formatos de imagen y vídeo, desde el JPEG hasta el H.265 y el AV1, se basan en la técnica del chroma subsampling: reducir la resolución del color respecto a la del brillo, asumiendo que el ojo apenas nota la pérdida. Los nuevos datos sugieren que esa suposición solo es válida para el eje azul-amarillo, pero no para el rojo-verde. En otras palabras, estamos comprimiendo demasiado la información cromática en una de las direcciones más sensibles de nuestra visión.

Cuando la nitidez se desvanece hacia los lados

El estudio también midió cómo cae la resolución en la periferia de la retina, donde la densidad de conos (las células fotorreceptoras del color) disminuye rápidamente. Como era de esperar, la agudeza visual se redujo drásticamente con la excentricidad, pero no de la misma forma para todos los colores.

Entre el centro de la visión (0°) y los 10°, la resolución achromática cayó unas 2,3 veces, mientras que la de rojo-verde lo hizo casi cinco veces. Esa diferencia es relevante para el diseño de sistemas de realidad virtual y renderizado foveado, una técnica que concentra los recursos gráficos en la zona que el ojo está mirando directamente.

Hoy, la mayoría de estos sistemas ajustan la resolución según la sensibilidad al contraste en blanco y negro. Incorporar la caída específica de los canales cromáticos podría ahorrar ancho de banda y potencia de cálculo sin que el usuario perciba degradación alguna.

Un modelo para diseñar pantallas más inteligentes

A partir de los datos experimentales, los investigadores ajustaron un modelo matemático del psicólogo Andrew Watson (NASA, 2018) que describe cómo la sensibilidad al contraste disminuye con la frecuencia espacial y con la distancia al centro de la visión. Este modelo les permitió extrapolar sus resultados a cualquier punto del campo visual y estimar la resolución retinal para distintas proporciones de la población.

Por ejemplo, si se diseña una pantalla que alcance el límite perceptivo para el 95% de los observadores, se necesitarían unos 94 ppd en el centro y al menos 22 ppd a 20° de excentricidad. El estudio muestra además que la variabilidad entre individuos es notable: algunos ojos distinguen el doble de detalle que otros.

El modelo también se traduce en términos más familiares para los ingenieros: pixeles por pulgada (ppi) y distancia de visionado. Según los autores, para que una televisión Full HD (1080p) sea realmente indistinguible de la realidad, habría que verla desde una distancia de seis veces su altura —el doble de lo que recomienda la Unión Internacional de Telecomunicaciones—. En cambio, una pantalla 8K solo ofrece ventajas perceptibles si se observa a menos de 1,3 alturas de distancia. Más allá, los píxeles adicionales son invisibles.

Nueva herramienta para el siglo de las pantallas

El equipo de Mantiuk no se ha limitado a publicar un artículo académico. En la web de Cambridge han puesto a disposición del público una calculadora interactiva que permite introducir el tamaño y la resolución de cualquier pantalla y obtener su densidad visual en píxeles por grado. Así, cualquiera puede comprobar si su monitor o televisor está realmente «a la altura del ojo humano».

Además, el estudio ofrece un ejemplo de aplicación directa: una imagen procesada mediante foveated filtering, que elimina las frecuencias espaciales invisibles en función de la distancia al punto de mirada. Visto desde la distancia adecuada, el resultado es indistinguible del original, pero con menos información digital. Esta técnica podría transformar la compresión de vídeo, reduciendo el tráfico de datos sin sacrificar calidad.

🗣️ «Nuestros resultados establecen una especie de estrella polar para el desarrollo de pantallas, con implicaciones para las futuras tecnologías de imagen, renderizado y codificación de vídeo», afirma el doctor Alex Chapiro, coautor del estudio e investigador en Meta Reality Labs.

En los entornos de realidad virtual y aumentada, donde las pantallas se colocan a pocos centímetros del ojo, alcanzar o superar los 90 píxeles por grado (ppd) podría marcar la frontera entre una imagen digital y una experiencia totalmente inmersiva. Foto: Minh Pham

Del laboratorio a la sala de estar.. y al metaverso

Más allá del interés científico, las implicaciones del trabajo son profundas para toda la industria visual. Las conclusiones invitan a redefinir los estándares de resolución retina que Apple popularizó hace más de una década y que se usan todavía como referencia comercial.

Para los fabricantes de televisores y móviles, estos hallazgos son un recordatorio de que aún hay margen para mejorar la nitidez de imagen; aunque quizás no merezca la pena si el ojo no lo aprecia a la distancia habitual de uso. En cambio, los campos de la realidad virtual y aumentada (VR/AR), donde las pantallas se sitúan a pocos centímetros del ojo, sí podrían beneficiarse de aprovechar todo el potencial de la visión humana. En ese contexto, alcanzar o superar los 90 ppd podría marcar la diferencia entre una imagen digital y una experiencia verdaderamente inmersiva.

Por otra parte, los resultados podrían inspirar mejoras en los algoritmos de codificación de vídeo y en la optimización de gráficos por computadora. Si sabemos con precisión qué detalles dejamos de percibir fuera de la zona central o en ciertos colores, podemos eliminar esa información antes de procesarla o transmitirla. En un mundo saturado de imágenes, eso se traduce en eficiencia energética, menor consumo de datos y menor huella de carbono digital.

Una mirada histórica: del alambre al píxel

El experimento de Cambridge recuerda a otro llevado a cabo en 1894 por el oftalmólogo y fisiólogo alemán Theodor Wertheim, quien midió la caída de la agudeza visual moviendo una rejilla de hilos frente al ojo. Mantiuk y su equipo repiten la esencia de aquella prueba, pero con la precisión de un motor paso a paso, pantallas 4K calibradas y análisis psicofísicos modernos.

Su conclusión, sin embargo, resuena con la de los pioneros: el ojo humano sigue siendo una maravilla de precisión biológica. Aunque la tecnología visual avance, nuestros límites perceptivos son más altos y complejos de lo que las fórmulas simplificadas habían hecho creer.

En la era de las pantallas omnipresentes, saber cuántos píxeles puede ver el ojo humano no es una curiosidad académica: es una guía para construir dispositivos más humanos, que aprovechen el poder —y los límites— de nuestra visión. ▪️

TAMBIÉN TE PUEDE INTERESAR:

👁️ Gafas holográficas ultraligeras: el futuro de la realidad mixta con IA y proyecciones 3D realistas

👁️ Sinapsis artificiales autoalimentadas que ven colores: la nueva frontera en la visión computacional

👁️ Unas lentes de contacto infrarrojas permiten ver en la oscuridad, incluso con los ojos cerrados

Información facilitada por la Universidad de Cambridge

Fuente: Ashraf, M., Chapiro, A. & Mantiuk, R. K. Resolution limit of the eye — how many pixels can we see? Nature Communications (2025). DOI: https://doi.org/10.1038/s41467-025-64679-2